Googlebot y SEO: Maximizando la Visibilidad en los Motores de Búsqueda

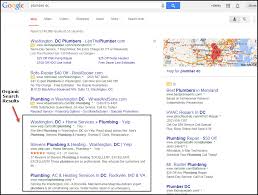

Googlebot es el robot de rastreo de Google que se encarga de explorar e indexar páginas web para mostrarlas en los resultados de búsqueda. Comprender cómo funciona Googlebot es fundamental para optimizar tu sitio web y mejorar su posicionamiento en los motores de búsqueda, es decir, para mejorar tu SEO (Search Engine Optimization).

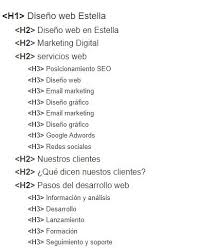

El objetivo principal de Googlebot es recorrer las páginas web en busca de contenido relevante y actualizado. Para asegurarte de que tu sitio sea rastreado correctamente, es importante tener un diseño web limpio y bien estructurado, con URLs amigables, metaetiquetas adecuadas y contenido de calidad.

Además, es fundamental tener en cuenta la velocidad de carga del sitio, ya que Googlebot prefiere sitios rápidos y eficientes. Optimizar imágenes, utilizar compresión de archivos y minimizar el uso de scripts innecesarios son algunas formas de mejorar la velocidad del sitio.

Otro aspecto importante a considerar es la creación de un archivo robots.txt para indicar a Googlebot qué páginas debe rastrear y cuáles no. También puedes utilizar las herramientas para webmasters de Google para monitorear el rendimiento de tu sitio y recibir notificaciones sobre posibles problemas.

En resumen, entender cómo funciona Googlebot y optimizar tu sitio web en consecuencia es fundamental para mejorar tu SEO y aumentar la visibilidad en los motores de búsqueda. Con un enfoque estratégico y continuo en la optimización del sitio, podrás atraer más tráfico orgánico y mejorar la presencia online de tu negocio.

Preguntas Frecuentes sobre Googlebot y su Impacto en el SEO de tu Sitio Web

- ¿Qué es Googlebot y cuál es su función en SEO?

- ¿Cómo puedo asegurarme de que Googlebot esté rastreando mi sitio web correctamente?

- ¿Qué aspectos debo considerar para optimizar la velocidad de carga de mi sitio para Googlebot?

- ¿Por qué es importante tener un archivo robots.txt en relación con Googlebot?

- ¿Cuáles son las herramientas recomendadas para monitorear el rendimiento de mi sitio web frente a Googlebot?

- ¿Cómo puedo mejorar la indexación y visibilidad de mi sitio en los resultados de búsqueda gracias a Googlebot?

¿Qué es Googlebot y cuál es su función en SEO?

Googlebot es el robot de rastreo de Google encargado de explorar y indexar páginas web para mostrarlas en los resultados de búsqueda. En términos de SEO, la función principal de Googlebot es analizar el contenido y la estructura de un sitio web para determinar su relevancia y calidad. Al comprender cómo funciona Googlebot y optimizar tu sitio web para que sea rastreado e indexado correctamente, puedes mejorar significativamente tu posicionamiento en los motores de búsqueda y aumentar la visibilidad online de tu negocio.

¿Cómo puedo asegurarme de que Googlebot esté rastreando mi sitio web correctamente?

Para asegurarte de que Googlebot esté rastreando tu sitio web correctamente, es importante seguir algunas prácticas clave de SEO. En primer lugar, verifica que tu sitio esté indexado en Google Search Console y monitorea regularmente los informes de rastreo para identificar posibles problemas. Asegúrate de tener un archivo robots.txt bien configurado para indicar a Googlebot qué páginas debe rastrear y cuáles no. Además, verifica que no haya errores en la estructura del sitio, como redirecciones incorrectas o enlaces rotos, que podrían dificultar el rastreo adecuado. Mantén tu contenido actualizado y relevante, utiliza metaetiquetas apropiadas y optimiza la velocidad de carga del sitio para garantizar una experiencia óptima para Googlebot y mejorar tu posicionamiento en los resultados de búsqueda.

¿Qué aspectos debo considerar para optimizar la velocidad de carga de mi sitio para Googlebot?

Para optimizar la velocidad de carga de tu sitio para Googlebot, hay varios aspectos importantes a considerar. En primer lugar, es fundamental tener un diseño web limpio y bien estructurado que facilite la carga rápida de las páginas. Además, es recomendable optimizar el tamaño de las imágenes y archivos multimedia, utilizar compresión de archivos para reducir el tiempo de carga y minimizar el uso de scripts innecesarios que puedan ralentizar el sitio. Asimismo, es importante asegurarse de contar con un buen servicio de hosting que garantice una conexión rápida y estable. Al mejorar la velocidad de carga de tu sitio, no solo estarás optimizando para Googlebot, sino también ofreciendo una mejor experiencia al usuario, lo que puede traducirse en un mejor posicionamiento en los resultados de búsqueda.

¿Por qué es importante tener un archivo robots.txt en relación con Googlebot?

Tener un archivo robots.txt es crucial en relación con Googlebot porque permite controlar qué páginas de tu sitio web deseas que sean rastreadas y indexadas por el motor de búsqueda. Al especificar qué áreas deben ser ignoradas por Googlebot a través de este archivo, puedes evitar que se indexen contenidos sensibles, duplicados o irrelevantes, lo que ayuda a mejorar la eficiencia del rastreo y la indexación de tu sitio. Además, el archivo robots.txt también puede indicar la ubicación del sitemap del sitio, lo que facilita a Googlebot encontrar y rastrear todas las páginas importantes de manera más efectiva. En definitiva, el archivo robots.txt es una herramienta fundamental para optimizar la visibilidad de tu sitio web en los resultados de búsqueda y garantizar que Googlebot acceda al contenido relevante para mejorar tu SEO.

¿Cuáles son las herramientas recomendadas para monitorear el rendimiento de mi sitio web frente a Googlebot?

Para monitorear el rendimiento de tu sitio web frente a Googlebot, existen varias herramientas recomendadas que te permitirán obtener información valiosa sobre cómo es rastreado tu sitio y qué aspectos puedes mejorar para optimizar tu SEO. Algunas de las herramientas más utilizadas incluyen Google Search Console, que te proporciona datos detallados sobre la indexación de tu sitio, posibles errores y mejoras sugeridas; Screaming Frog, que te permite realizar un análisis exhaustivo del rastreo de tu sitio y detectar posibles problemas técnicos; y SEMrush, una herramienta completa que ofrece información sobre el rendimiento SEO de tu sitio y el comportamiento de Googlebot. Estas herramientas te ayudarán a tener un mayor control sobre cómo Googlebot interactúa con tu sitio web y a tomar medidas para mejorar su visibilidad en los motores de búsqueda.

¿Cómo puedo mejorar la indexación y visibilidad de mi sitio en los resultados de búsqueda gracias a Googlebot?

Para mejorar la indexación y visibilidad de tu sitio en los resultados de búsqueda gracias a Googlebot, es fundamental seguir algunas prácticas clave de SEO. En primer lugar, asegúrate de tener un diseño web limpio y bien estructurado que facilite la navegación tanto para los usuarios como para Googlebot. Optimiza tus metaetiquetas, utiliza palabras clave relevantes en tu contenido y crea una estrategia de enlaces internos para mejorar la relevancia de tus páginas. Además, mantén tu sitio actualizado con contenido fresco y de calidad, y asegúrate de que sea compatible con dispositivos móviles y tenga tiempos de carga rápidos. Al implementar estas prácticas recomendadas, podrás aumentar las posibilidades de que Googlebot rastree e indexe tu sitio de manera efectiva, lo que se traducirá en una mejor visibilidad en los resultados de búsqueda.